ランディングページやEメールの文面を作成したり、CTA(Call-To-Action)のボタンをデザインする際、クリックやコンバージョンを増やすための方法を直感で判断してしまいがちです。

しかし、マーケティングに関する判断を感覚に頼ってしまうと、結果に悪影響を及ぼす可能性があります。そこで、仮説や推測を基に判断を下すよりも、はるかに良い結果を得るための方法がA/Bテスト(またはスプリットテスト)です。

A/Bテストを実施する理由は、オーディエンスが変われば行動も変わるということにあります。

ある会社で成功した手法が別の会社でも成功するとは限りません。「ベストプラクティス(最適な手法)」と呼ばれる手法が、実は自社にとって最適とは言えない場合もあります。

そのため、CRO(コンバージョン率の最適化)に詳しい専門家は、「ベストプラクティス」という言い方自体を嫌がるものです。

もちろん、A/Bテストが簡単とは限りません。綿密な準備を怠ってしまうと、判断を誤ってしまいます。そして、その誤った判断によって、マーケティング戦略の他の部分にまで悪影響が及ぼす場合もあります。

この記事では、A/Bテストの結果から最適な判断を下せるように、テストの実施前、実施中、実施後のそれぞれについて進め方のポイントを解説します。

A/Bテストとは?

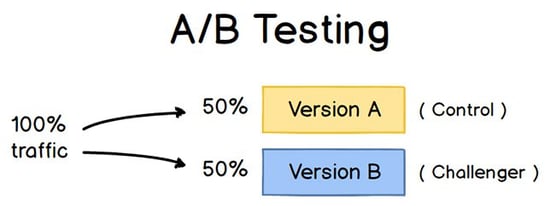

A/Bテスト(スプリットテストとも呼ばれる)とは、キャンペーンのバリエーションを複数用意し、それぞれにオーディエンスを振り分けて、結果が良くなるバリエーションを検証するマーケティング実験の手法です。

たとえば、あるマーケティングコンテンツについて、オーディエンスの半分にはバリエーションAを見せ、残りの半分にはバリエーションBを見せるといった方法で実施します。

A/Bテストを実施するには、まず1つのコンテンツに対して異なる2つのバージョンを作成します。このとき、2つのバージョンの間で変えるのは、1つの要素に限定します。そして、この2つのバージョンをそれぞれ同じくらいの人数のオーディエンスに見せて、一定の時間(テスト結果について正しい判断を下すために必要な時間)が経過した後、どちらの結果が良かったかを分析します。

画像提供:ConversionXL

A/Bテストを実施すれば、複数のバージョンで、その結果を比較することができます。ウェブサイトのコンバージョン率向上を目的とする場合は、次の2つのタイプのA/Bテストを実施することをお勧めします。

タイプ1:ユーザーエクスペリエンスのテスト

たとえば、サイドバーの中にあるCTAボタンをトップページの上部に移した方が、クリックスルー率の改善につながるのではないかという仮説を立て、それを検証したいとします。

この仮説をA/Bテストで検証するには、既存のページのほかに、CTAの位置を変更したページを作成し、既存のページ(統制群)をバージョンA、新しいページ(実験群)をバージョンBとします。

そして、あらかじめ決めておいた割合でサイトの訪問者を分割し、それぞれのグループに各バージョンを見せて、テストを実施します。

なお、各バージョンを表示する訪問者の割合は同じにするのが理想的です。

タイプ2:デザインのテスト

今度は、CTAボタンの色を変えればクリックスルー率が改善するのではないかという仮説を立て、それを検証したいとします。

この仮説をA/Bテストで検証するには、統制群と同じランディングページに誘導するCTAボタンを作成し、色だけを変更します。たとえば、これまでマーケティングコンテンツではCTAボタンを赤くしていたものの、A/Bテストを実施したところ、緑の方がクリック数が多かった場合、今後は緑を既定の色にすればよいということになります。

A/Bテストを実施するメリット

A/Bテストがマーケティング部門にもたらすメリットは、テストの対象によってさまざまですが、最大のメリットは、小さいコストで大きなリターンを得られることにあります。

たとえば、年俸500万円で雇用しているコンテンツ作成担当者が、自社のブログ記事を週に5本、1年間で260本(5本×52週)投稿していると仮定します。

ブログ記事1本あたりのリード獲得数の平均が10人の場合、リードを10人獲得するのに約19,000円(年俸500万円÷記事260本)費やしていることになります。これは決して小さい数字ではありません。

そこで、このコンテンツ作成担当者に、2日で2本の記事を書く代わりに、記事を1本作成した後、その記事のA/Bテストを実施するよう依頼します。

すると、投稿する記事が1本減るので19,000円が無駄になるかもしれませんが、A/Bテストの結果、記事1本あたりのリード獲得数を10人から20人まで引き上げられる可能性があることが判明した場合は、ブログで獲得できる顧客の人数をわずか19,000円で倍増できることになります。

もちろん、テストが失敗した場合、その19,000円は完全に無駄になりますが、その経験を次回のA/Bテストに活かすことができます。

そして、2回目のA/Bテストが成功して、ブログのコンバージョン率が倍になれば、収益の倍増に向けて投じた最終的な費用は38,000円ということになります。

A/Bテストの失敗が続いても最終的に成功すれば、テストに費やした費用よりも大きな見返りを得られるというケースは少なくありません。

A/Bテストのメリットを引き出す方法はさまざまですが、マーケティングのA/Bテストの場合は、次のような目的で実施するのが一般的です。

- ウェブサイトのトラフィックの増加:ブログ記事やウェブページのタイトルを変えてテストすると、そのページのリンクをクリックする人が増え、ウェブサイトのトラフィックが増加する可能性があります。

- コンバージョン率の向上:CTAの場所や色、アンカーテキストを変えてテストすると、CTAをクリックしてランディングページにアクセスする人が増える可能性があります。これにより、フォームに入力して連絡先を提供し、リードに「転換」する訪問者が増えると考えられます。

- バウンス率の低下:ウェブサイトにアクセスしてきたユーザーがすぐにサイトを離脱(バウンス)している場合、ブログ記事の紹介文やフォント、アイキャッチ画像を変えてテストすると、ユーザーがサイトに滞在する時間が長くなり、バウンス率が低下する可能性があります。

- カート放棄率の低下:米国カリフォルニア州を拠点にバーチャル電話システムの開発を手がけるMightyCallのブログ記事によると、eコマースサイトでは、顧客の40~75%がショッピングカートに商品を入れたままサイトを離脱しており、こうした現象は「カート放棄」や「カゴ落ち」と呼ばれています。そこで、製品の画像や決済ページのデザイン、あるいは送料の表示位置を変えてテストすると、カート放棄率を低減できる可能性があります。

ここからは、A/Bテストの準備から結果の評価までの手順を、チェックリスト形式で説明していきます。

A/Bテストの進め方

ここからは、どのようにA/Bテストを実践していくべきか具体的な手順と共に解説していきます。

ここからは、どのようにA/Bテストを実践していくべきか具体的な手順と共に解説していきます。

A/Bテスト前の手順

1. テストの対象となる要素を1つ選択する

ウェブページやEメールの最適化にあたっては、テストの対象にしたい要素がいくつも心に浮かぶはずです。

しかし、テスト対象の要素が2つ以上あると、パフォーマンスを変化させた要素を特定できなくなるため、テスト結果を正しく評価するには、1つの要素だけを「独立変数」として変化を測定する必要があります。

1つのページやEメールで複数の要素をテストする場合は、1回のテストで対象となる要素を1つに限定するようにしましょう。

テストの対象となる要素は、マーケティングコンテンツのデザイン、文面、レイアウトなどさまざまなものが考えられます。また、Eメールの件名や送信者の名前、パーソナライズ可能な部分についてもテストの対象となる場合があります。

注意していただきたいのは、Eメールの画像やCTAボタンのテキスト(英語)のようなちょっとした要素を変えるだけでも、パフォーマンスが大きく改善する可能性があるということです。

それどころか、こうした細かい要素を変更する方が、コンテンツに大きく手を加えるよりも成果を測定しやすいのが通常です。

補足:テストの対象を1つに限定するよりも、複数の要素をまとめてテストした方が有効な場合もあり、こうした手法を「多変量テスト」と呼びます。A/Bテストと多変量テストのどちらを実施すればよいのかわからない場合は、テスト用プラットフォームの開発を手がけるOptimizelyが2つのテストを比較した記事(英語)が参考になります。

2. 目標を明確にする

テストで測定の対象となり得る指標は数多くありますが、その中でも特に重視する指標を、テストの前、具体的には実験群となるバージョンBを準備する前に決めておきましょう。ここで決めた指標が「従属変数」に当たります。

そして、この指標がA/Bテストを実施した後にどう変化しているべきかを検討し、その内容を1つの仮説として定式化して、テストを実施したら、その仮説を基に結果を分析しましょう。

重視する指標や目標、テストによるユーザーの行動への影響は、テストの前にあらかじめ検討しておかなければ、テストを効果的に実施するための準備ができません。

3. 統制群と実験群を設定する

ここまでの手順で、テストの独立変数と従属変数、目標とする結果が明確になったところで、その情報を基に、テストの統制群として、コンテンツに何の変更も加えていないバージョンを準備します。

たとえば、ウェブサイトのテストでは、既存のサイトがそのまま統制群となり、ランディングページのテストでは、普段使用しているランディングページのデザインや文面が統制群に該当します。

そして、統制群となるサイトやランディングページ、Eメールなどに変更を加えた実験群を作成します。

たとえば、ランディングページに顧客の声を含めることで、コンバージョン率が改善するかどうかを知りたいときは、顧客の声を含まないバージョンを統制群、顧客の声を含むバージョンを実験群として作成します。

4. サンプルグループを同じ人数でランダムに分割する

オーディエンスを細かく調整可能な場合(Eメールのテストなど)、有意な結果を得るには、同じ人数のオーディエンスを複数用意することが必要です。

その方法はA/Bテストで使用するツールによって異なりますが、たとえばHubSpotのEnterprise版でEメールのA/Bテストを実施する場合は、トラフィックが自動的に分割され、それぞれのバージョンにサンプルがランダムに振り分けられます。

5. サンプルサイズを決定する(必要な場合)

サンプルサイズの決め方も、A/Bテストに使用するツールや実施するA/Bテストの種類によって変わってきます。

たとえば、EメールのA/Bテストでは、オーディエンスに含まれる一部のユーザーに対してA/Bテスト用のEメールを送信し、統計的に有意な結果を入手したら、結果が良かった方のバージョンを選んで、残りのオーディエンスに送信することになるでしょう(サンプルサイズの計算方法については、この記事の最後に紹介している、効果的なA/Bテストの実施方法について解説したeBookをご覧ください)。

また、HubSpotのEnterprise版には、サンプルグループのサイズをスライダーで調整できる機能が搭載されており、サンプルを50:50の割合で分割する場合にのみ、サンプルサイズを自由に設定することができます(なお、50:50以外の割合にする場合は、Eメールの宛先が1,000件以上必要になります)。

ウェブページのようにオーディエンスの範囲が明確でないものをテストする場合は、テストの実施期間がサンプルサイズに大きな影響を与えます。ページの閲覧数が十分になるまでテストを続けないと、2つのバージョンの間に統計的に有意な差があるかどうかを判断するのが難しくなります。

6. 結果にどの程度の有意性を求めるかを決める

目標とする指標が決まったら、どちらのバージョンを選ぶか判断するために必要な有意性の基準を検討します。統計的有意性は、A/Bテストを実施するうえで非常に重要な意味を持ちますが、誤解されていることも少なくありません。統計的有意性についてマーケティングの観点から改めて確認したい方は、こちらのブログ記事(英語)をお読みになることをお勧めします。

テストの結果は、「信頼水準」のパーセントが高ければ高いほど信頼性を実感できるため、ほとんどの場合、最低95%の信頼水準が必要になります。特にテストの準備に時間がかかる場合は、98%以上あることが理想的です。一方、テストにそこまでの厳密性を求めない場合は、信頼水準が低めでも問題ないこともあります。

HubSpotのシニア ソフトウェア エンジニアであるMatt Rheaultは、統計的有意性を一種の賭け事のように考えればよいと述べています。

オッズがどれくらいあれば安心して賭けられるかを想像して、たとえば「私は80%の確率でこのデザインが適切だと考えており、このデザインにすべてを賭けてもよい」と考えたのであれば、A/Bテストを80%の信頼水準で実施して、効果的なバージョンを判断するのと同じことになります。

さらにRheaultは、コンバージョン率がごくわずかしか改善しない場合、そのテストでは信頼水準を高めにした方がよいとも述べています。というのも、無作為の分散による影響が大きくなるからです。

Rheaultは次のように説明しています。「信頼水準を下げても問題ないのは、たとえばウェブページの中でも目立つ部分のデザインをリニューアルするなど、コンバージョン率が10%以上改善することを期待できるテストの場合です。

つまり、変更の規模が大きくなるほど、プロセスの面で厳密性を求める必要が小さくなります。

一方、ボタンの色や一部のテキストなど、変更する範囲が限定的になると、その変更によってコンバージョン率に大きな影響が及ぶ可能性は低くなるので、より厳密なプロセスが必要になります」

7. どのキャンペーンでもテストの対象は1回につき1要素に限定する

1つのキャンペーンで複数の対象についてテストを行うと、仮に、対象を異なるマーケティングアセットに掲載する場合であっても、結果の分析が複雑になるおそれがあります。

たとえば、EメールキャンペーンのA/Bテストを実施するのと同時に、そのEメールの誘導先となるランディングページのA/Bテストも実施した場合、どちらの変更によってリードが増加したのかを判断できなくなる可能性があります。

A/Bテスト中の手順

8. A/Bテスト用ツールを使用する

ウェブサイトやEメールのA/Bテストを実施するには、専用のテストツールが必要になります。HubSpotのEnterprise版をご利用の場合は、HubSpotのA/Bテスト機能を利用すれば、Eメール、CTA、ランディングページのテストを実施できます(詳しい手順はそれぞれのリンク先をご覧ください)。

HubSpotのEnterprise版をご利用でない場合は、Google オプティマイズのウェブテスト機能が候補になります。ターゲット設定したユーザーを対象としてウェブページのA/Bテストを実施し、ページのパフォーマンスを比較することができます。

9. 2つのバージョンを同時にテストする

マーケティングキャンペーンの成果は、時間帯、曜日、月といったタイミングによって大きく左右されます。たとえば、バージョンAとバージョンBのテストの時期を1か月ずらした場合、結果が変わったのはデザインの違いによるものか、あるいはタイミングの違いによるものかを判断することが難しくなります。

A/Bテストを実施する際は、結果に関する当て推量ばかりに時間を割くことがないように、2つのバージョンを同時にテストすることが必要です。

ただし、1つだけ例外があります。それは、Eメールを配信するのに最適な時間など、タイミング自体をテストの対象にする場合です。Eメールの受信登録者のエンゲージメントを高めるのに最適なタイミングは、自社が提供している商品やサービスのほか、受信者の業種やターゲット市場によっても大きく異なる場合があるので、配信のタイミングをテストの対象とするのは効果的な手法です。

10. 有益なデータを得るために十分な時間をかけてA/Bテストを実施する

繰り返しになりますが、A/Bテストはサンプルサイズが十分な大きさになるまで続ける必要があります。テストの期間が足りない場合、2つのバージョンの間に統計的に有意な差があるかどうかを判断しにくくなります。

では、どの程度の時間をかければ十分なのでしょうか? 統計的に有意な結果を得るためには、自社でA/Bテストをどのように実施するかによって、数時間から数日、あるいは数週間もかかる場合があります。有意な結果を得るまでの時間は主にトラフィックの量に左右されるため、ウェブサイトのトラフィックが少なければA/Bテストに必要な時間も長くなります。

理論上は、データを収集する期間に制限をかけるべきではないと考えられます(サンプルサイズやタイミングについては、こちらのブログ記事(英語)をご覧ください)。

11. 実際のユーザーにフィードバックを依頼する

A/Bテストを実施することで大量のデータを収集できますが、だからといって、オーディエンスが特定の行動を他の行動より優先した理由まで解明できるとは限りません。A/Bテストを実施する際は、ぜひ実際のユーザーから(定量的ではなく定性的な)フィードバックも集めてみてください。

フィードバックを集めるのに最適な方法の1つは、アンケートを実施することです。サイトを離脱しようとしている訪問者にアンケートを表示して、特定のCTAをクリックしなかった理由を質問したり、コンテンツのダウンロードページで、ボタンのクリックやフォームの入力を行った理由を質問したりするとよいでしょう。

たとえば、eBookのダウンロードページに誘導するCTAをクリックする人は多くても、商品価格の提示後にコンバージョンにつながっていないという状況に気付いたとして、ユーザーのフィードバックを集めておくことで、ユーザーの行動の理由を知るためのさまざまなヒントを入手できます。

A/Bテスト後の手順

12. テスト前に目標として設定した指標に注目する

繰り返しになりますが、複数の指標についてデータを測定したとしても、分析の対象はテスト前に目標として設定した指標に限定しましょう。

たとえば、Eメールのテストを2つのバージョンで実施し、リードの獲得数を主要な指標に設定していた場合、Eメールの開封率やクリックスルー率に気を取られないようにします。片方のバージョンのクリックスルー率が高くてもコンバージョン率が低ければ、最終的にクリックスルー率が低い方のバージョンを選択することも考えられます。

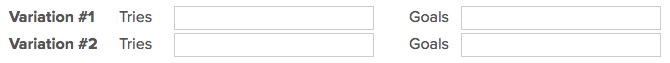

13. A/Bテストの検定ツールを使って結果の有意性を評価する

どちらのバージョンのパフォーマンスが優れているかが判明したところで、次は統計的に有意な差がテストの結果にあるかどうか、つまり変更を行う価値があるかどうかを判断します。

そのためには、統計的有意差の検定が必要です。Eメールの送信件数やページのインプレッション数など、テストの合計試行回数をバージョンごとに入力した後、目標を達成した回数を入力します。クリック数が一般的ですが、それ以外のコンバージョンの場合もあります。

入力すると、結果が良かったバージョンについて、データの信頼水準が出力されるので、テスト前に決めておいた基準と比較して、統計的に有意な差かどうかを判断します。

14. 結果に応じて措置を講じる

2つのバージョンの間で統計的に有意な差があれば、効果の高いバージョンを特定できるので、もう一方のバージョンをA/Bテスト用ツールで無効にして、テストを終了します。

2つのバージョンの間で統計的に有意な差がない場合は、テスト対象の要素が結果に与える影響はなかったということであり、そのテストから何かを判断することはできません。この場合、元のバージョンを使用し続けるか、要素を変えてテストを実施することになります。失敗したテストのデータを参考にして、次のテストを実施するための計画を立てましょう。

A/Bテストは特定のキャンペーンの効果を高めるために実施するものですが、それぞれのテストで得た知見は今後の取り組みに活かすことができます。たとえば、EメールマーケティングのA/Bテストを実施して、Eメールの件名に数字を含めるとクリックスルー率が向上することが繰り返し確認された場合、その手法を他のEメールにも取り入れることを検討するとよいでしょう。

15. 次のA/Bテストの計画を立てる

A/Bテストを実施した結果、マーケティングコンテンツの効果を改善する方法が新しく見つかったとしても、それで終わりというわけではありません。常に改善の余地はあるはずです。

テストを実施したばかりのウェブページやEメールに対し、別の要素でA/Bテストを実施してもかまいません。たとえば、ランディングページの見出しを対象にしてテストを実施したのであれば、次は本文のテキストやページの配色、画像についてテストしてみませんか? コンバージョン率やリード獲得数を伸ばせるチャンスはないか、常に目を光らせておきましょう。

マーケティングにおける分析の手順については、効果的な実施方法を以下のeBookで詳しく説明しています。ぜひご覧ください。